카멜레온에 대해 알아보기 전에…

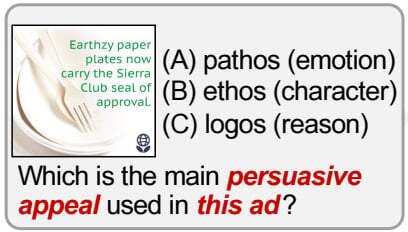

카멜레온LLM이 무엇이며 어떤 능력이 있는지 알아보기 전에, 우선 왼쪽에 문제를 하나 보여드리겠습니다. “Earthzy 종이접시는 Sirra Club의 인증마크를 받았습니다”라는 문구가 적힌 광고 이미지와 함께, 이 광고에 사용된 설득법이 무엇인지 묻고 있습니다. 보기의 (A)감성(Pathos), (B)인성(Ethos), (C)이성(Logos) 중에 골라야 하는데, 단번에 답을 고를 수 있는 문제는 아닌 것 같습니다. 광고 이미지도 해석해야 하고 Pathos·Ethos·Logos가 뭔지도 알아봐야 하고, 이 정보들을 종합해 어떤 답이 적합할지 고민도 해야 하기 때문입니다.

다양한 툴을 활용하는 카멜레온LLM

이런 복잡한 문제를 인간처럼 (혹은 인간보다 더 잘) 해결할 수 있는 LLM이 등장했습니다. 지난 4월 UCLA와 마이크로소프트 연구진이 개발한 “카멜레온 LLM”이라고 하는 플러그앤플레이 구성의 추론 프레임워크인데요. 기존 LLM은 최신정보에 대한 접근이나 세밀한 수학적 추론이 불가능해 복잡한 실생활 쿼리(질문)을 수행하는 데 한계가 있었습니다. 이를 보완하고자 카멜레온LLM은 GPT-4, HuggingFace, GitHub, Python, 마이크로소프트 검색엔진 Bing과 같이 다양한 툴을 자동으로 활용해 쿼리를 수행합니다.

※ LLM : Large Language Model, 거대 언어 모델로 대규모의 텍스트 데이터를 기반으로 학습할 수 있는 인공지능 툴. OpenAI의 챗GPT와 구글의 바드 등이 있다.

다시 종이접시 광고 문제로 돌아가 보겠습니다. 이 문제는 카멜레온LLM 논문에 소개된 사례들 중 하나로, 카멜레온이 이 문제를 어떻게 해결하는지 한번 살펴보시죠. 카멜레온은 GitHub의 Text Detector로 광고 속 텍스트를 감지하고, GPT-4를 통해 질문과 보기의 정보를 파악해 솔루션을 생성합니다. “Sierra Club의 신뢰도와 명성에 기대어 어필하고 있기 때문에, 인성(Ethos)의 사례로 볼 수 있다”고 말입니다. 복잡한 맥락 속에서 정답을 도출해내는 능력, 놀랍지 않으신가요?

이미지 해석 툴(HuggingFace) 활용한 쿼리 수행

논문 속 또 다른 예시에서는 이미지를 해석하는 HuggingFace 툴도 활용합니다. 사진과 함께 질문을 던지면 카멜레온은 HuggingFace를 활용해 “북극곰이 눈밭에 서 있다”고 이미지를 해석합니다. GPT-4로 “추운 환경에 적합한 동물의 피부”라는 질문을 뽑아내고 검색엔진 Bing으로는 서치도 해 봅니다. GPT-4가 다시 이 정보들을 바탕으로 문제의 맥락을 파악해 솔루션을 도출해 냅니다. 문맥 속에서 가장 그럴 듯한 답은 더 추운 지역에 서식하는 “(A)유라시안스라소니”라고 말이죠.

표 해석과 수학적 추론도 가능

다양한 툴을 활용할 수 있으니, 표를 해석하는 쿼리도 카멜레온에겐 문제 없습니다. 완다가 매일 하이킹한 거리(마일)를 표로 제시하며, 중간값(median)을 찾으라는 질문입니다. 카멜레온은 GPT-4를 활용해 지식을 검색하고(중간값이란 무엇인가?) 표를 언어로 해석해봅니다(표에 어떤 내용이 들어있나?). 얻어낸 정보를 바탕으로 표의 값을 단순화하고 파이선 코드로 계산해, 카멜레온은 9를 정답으로 도출해냈습니다.

인간보다 정확한 카멜레온LLM

카멜레온 연구자들은 다양한 추론능력을 요구하는 복잡한 쿼리도 카멜레온 하나로 수행해낼 수 있기에 유연성과 효율성 측면에서 다른 LLM과 구별된다고 주장합니다. 과학적 질의응답(ScienceQA)과 표 형태의 수학 문제 해결(TabMWP) 두 가지 태스크를 통해 이 부분을 증명했는데요. GPT-4를 활용한 카멜레온은 ScienceQA와 TabMWP 태스크 모두에서 다른 모델들보다 나은 결과를 보여줬고, 특히 TabMWP 태스크에서는 사람(점선으로 표시)보다 8.56%p 더 나은 성적을 보이기도 했다고 논문은 주장하고 있습니다.

카멜레온의 능력은 어디까지?

카멜레온LLM은 현재 연구와 비상업적인 목적으로만 활용 가능하지만, 이미 많은 이들이 관심을 가지고 지켜보고 있는 기술입니다. 복잡한 쿼리를 수행할 수 있는 LLM을 직접 개발하려면 시간과 비용이 만만치 않을 텐데, 플러그 앤 플레이 방식으로 바로 사용할 수 있는 LLM이 등장했으니 산업계에서도 환영할만한 이슈라고 생각합니다. 향후 LLM과 같은 여러 가지 툴이 발전을 거듭할수록 카멜레온도 훨씬 더 복잡하고 다양한 과제를 수행할 수 있겠죠. 이러한 잠재력을 생각한다면, 앞으로 구독자 여러분도 두 눈 크게 뜨고 지켜봐야 할 기술이 아닐까 합니다.

텐투플레이도 LLM 모델을 제품에 접목하기 위한 연구를 꾸준히 진행하고 있습니다. 게임 유저 개인화 분석 툴 텐투플레이는, LLM을 비롯한 AI기술 연구를 통해 다양한 행동 패턴의 유저들을 발견하여 맞춤형 이벤트를 진행하는데 활용할 수 있도록 노력하고 있습니다. AI기술의 발전과 함께 여러분의 게임에 더욱 깊은 인사이트를 제공할 텐투플레이의 행보를 지켜봐주세요!

<Reference>

Pan Lu, Baolin Peng, Hao Cheng, Michel Galley, Kai-Wei Chang, Ying Nian Wu, Song-Chun Zhu, Jianfeng Gao, “Chameleon: Plug-and-Play Compositional Reasoning with Large Language Models”, arXiv preprint arXiv:2304.09842(2023).

![[Tech/Biz Trend] 쿨하지 못한 OpenAI, 어딘지 낯설다](https://mobiinsidecontent.s3.ap-northeast-2.amazonaws.com/kr/wp-content/uploads/2025/12/11165610/251212_OpenAI-%EC%BD%94%EB%93%9C-%EB%A0%88%EB%93%9C_01-218x150.png)

![[Meta Korea가 공유하는 메타 광고 꿀팁!] 2026을 결정짓는 ‘성장 체질’ – AI 시대의 마케팅 ①](https://mobiinsidecontent.s3.ap-northeast-2.amazonaws.com/kr/wp-content/uploads/2025/12/08112014/251208_%EC%A0%84%ED%99%98%EC%9D%98-%EB%AC%B4%EA%B8%B0-AI_%EC%84%AC%EB%84%A4%EC%9D%BC-218x150.jpg)

![[MOBI-INSIGHT] ‘메타코리아와 함께 보는 2026 비즈니스 트렌드’ 발표 현장 리뷰](https://mobiinsidecontent.s3.ap-northeast-2.amazonaws.com/kr/wp-content/uploads/2025/12/05143812/251205_Meta-2026-%EB%B9%84%EC%A6%88%EB%8B%88%EC%8A%A4-%EC%84%A4%EB%AA%85%ED%9A%8C_01-218x150.jpg)